Pierwsze komputery i narodziny epoki cyfrowej. Od Z1 do PC

W XXI wieku nie wyobrażamy sobie życia bez komputerów. Od codziennej komunikacji po loty kosmiczne, te uniwersalne maszyny napędzają nasz świat. Dzięki nim możemy sprawniej poruszać się w rzeczywistości lub całkowicie od niej uciec w gry VR. Jak wielkie maszyny do liczenia stały się uniwersalnym narzędziem cywilizacji? Oto historia tego przełomowego wynalazku.

Jeśli szukasz więcej informacji i ciekawostek historycznych, sprawdź także zebrane w tym miejscu artykuły o wynalazcach.

Z czego składa się komputer?

Przepis na komputer

Komputerem można nazwać każdą maszynę, która potrafi odczytać i wykonać zakodowane instrukcje. Główna różnica, która dzieli komputer od kalkulatora to możliwość programowania. Nawet najstarsza maszyna analityczna z XIX wieku (o której napiszę dalej) była teoretycznie w stanie wykonać program. Architektura komputerów została opisana przez dwóch wybitnych matematyków w latach 30-tych i 40-tych XX wieku – Alana Turinga (Ritchie D., 1986: s. 77) i Johna von Neumanna. Żeby nasz komputer mógł funkcjonować tak jak opisano powyżej, musi spełniać pewne warunki:

- urządzenia wejścia-wyjścia przyjmują instrukcje i zwracają wyniki

- pamięć przechowuje zmienne i instrukcje

- jednostka arytmetyczno-logiczna przetwarza informacje

- jednostka sterująca ma dostęp do pamięci, umożliwia wykonanie przyjętych instrukcji.

Komputer potrzebuje własnego źródła energii. W przeciwieństwie do suwaka logarytmicznego, mechanicznych kalkulatorów i arytmometrów jest w pełni automatyczny. Ten ostatni warunek sprawił, że budowa komputera zaczęła być realna dopiero w XIX wieku. Ludzie od stuleci korzystali z kodów liczbowych, maszyn różnego rodzaju, również maszyn liczących. Wszystko działo się jednak w głowie, na papierze lub, w najlepszym przypadku, w wyniku używania dźwigni, sprężyn, kółek zębatych czy ciężarków. Sytuacja zmieniła się kiedy w powszechne użycie wszedł udoskonalony silnik parowy.

Maszyna Babbage’a i pierwsza programistka

Pierwszy programowalny komputer w historii miał być zasilany właśnie silnikiem parowym. W roku 1822 angielski wynalazca Charles Babbage zbudował pierwszą maszynę różnicową. To jeszcze nie był komputer, a raczej ogromny mechaniczny, zautomatyzowany kalkulator. W następnej dekadzie zaczął pracować nad maszyną analityczną, która miała wszystkie podstawowe cechy współczesnego komputera. Była programowalna (za pomocą kart perforowanych – pomysł zapożyczony od Jacquarda), posiadała osobną jednostkę pamięci i jednostkę analityczną. Zasilanie silnikiem parowym pozwalało na zautomatyzowaną pracę. (Petzold Ch., 2002: s. 267-268) Projekt nigdy nie został dokończony. W czasach Babbage’a był bardzo kosztowny. Koszt i złożoność urządzenia były niewspółmierne do zapotrzebowania na tego typu sprzęt. Złożone obliczenia można było przecież wykonywać za pomocą liczydeł, ręcznie sterowanych, niewielkich arytmometrów i suwaków.

Współpracownicą Babbage’a i autorką pierwszych programów była Ada Byron-King, księżna Lovelace. Córka znanego romantycznego poety George’a Byrona i wszechstronnie wykształconej (m.in. matematycznie) Anny Izabeli (Anabelli) Byron. (Petzold Ch.: s. 268)

U progu ery cyfrowej

Projekt Konrada Zuse

Za pierwszego konstruktora komputera w nowoczesnym rozumieniu uważa się niemieckiego inżyniera Konrada Zuse. Opatentował on w 1936 roku pamięć, która mogła być odczytywana przez jednostkę sterującą komputera. Pamięć opierała się na przesuwanych automatycznie blaszkach. W 1938 roku powstał prototyp komputera V1, przemianowany później na Z1. Najbardziej nowatorskim pomysłem Zuse było zastosowanie liczb binarnych, czyli przedstawianych za pomocą zer i jedynek. Możliwość przedstawienia nawet największych liczb za pomocą zer i jedynek pozwalała reprezentować je przez odpowiednio długie ciągi prostych impulsów elektrycznych. Ma to jeszcze jedną zaletę. Łatwo jest przejść od działań na liczbach do działań logicznych, gdzie zamiast zer i jedynek jest „prawda” i „fałsz”.

Z1 był projektem finansowanym przez społeczność, a dokładniej przez rodzinę i przyjaciół młodego inżyniera. Prototyp nigdy nie był w pełni sprawny, ze względu na zawodność blaszek. Ostatecznie został zniszczony w czasie bombardowania Berlina w 1943 roku.

Pierwszą w pełni programowalną wersją komputera był model Z3, niestety używany przez niemieckie lotnictwo w czasie II wojny światowej. (Lee J.A.N.: s. 765-766) Zuse nie był ideologicznie związany z III Rzeszą, ale nie był też w opozycji. Należał do grona naukowców i inżynierów, którzy po prostu wykonywali swoją pracę. Niezależnie od wszystkiego jego wynalazek był przełomowy. Inne maszyny Zuse służyły do obliczeń w celach naukowych i komercyjnych. Po wojnie prowadził firmę Zuse KG, która później została wchłonięta przez korporację Siemens. Sprawdź także ten artykuł na temat 10 najważniejszych wynalazków w historii.

Enigma i pierwsze komputery

II wojna światowa była czasem przełomowym w historii komputerów. Możliwość zdalnej komunikacji świetnie nadawała się dla celów wojennych. Miała jedną wadę – przeciwnik mógł przechwycić rozkazy, podłączając się do sieci kablowej lub łapiąc odpowiednią częstotliwość radiową. Dlatego szybko zaczęły się rozwijać techniki szyfrujące. Pod koniec I wojny światowej Artur Schreibus skonstruował maszynę szyfrującą, która opatentował w 1918 roku i od 1923 sprzedawał pod komercyjną nazwą Enigma. Pod koniec lat 30-tych zaczęło jej używać wojsko III Rzeszy. Innym urządzeniem, używanym przez niemieckie dowództwo, była maszyna Lorenza.

Rozszyfrowanie instrukcji kodowanych za pomocą Enigmy i maszyny Lorenza było kluczowe dla przewidywania ruchów przeciwnika. Liczyła się szybkość i bezbłędność. Dlatego postanowiono użyć maszyn analitycznych. Colossus, skonstruowany w 1943 roku, jest uważany za pierwszy cyfrowy, binarny i programowalny (ręcznie) komputer. Jego zadaniem było rozkodowanie informacji przekazywanych dalekopisem przez maszynę Lorenza. Do rozkodowania Enigmy używano urządzenia mechaniczno-elektycznego o nazwie Bomba. Skonstruowali je jeszcze przed wojną polscy kryptolodzy. Brytyjska Bombe została przystosowana do nowych metod szyfrowania jakie Niemcy wprowadzili po wybuchu wojny. W konstrukcji Colossusa i Bombe pomagał m.in. Alan Turing, autor hipotetycznego komputera wzorcowego, zwanego maszyną Turinga. (Ritchie D.: s. 78-79)

Zimna wojna i komputerowy boom

Najbardziej dynamiczny rozwój cyfryzacji nastąpił między 1945 a 1989 rokiem, czyli w okresie zimnej wojny. Warunki sprzyjające rozwojowi komputerów miały wielorakie podłoże m.in. boom gospodarczy w USA, dostępność surowców i technologii. Wojna światowa zmusiła obie strony do przyspieszonego rozwoju już wcześniej znanych technologii. Zapotrzebowanie na dalsze udoskonalanie technologii było napędzane przez wyścig zbrojeń i rywalizację w podboju kosmosu, ale też przez rosnące potrzeby komercyjne i społeczne. Pokolenia urodzone po II wojnie światowej coraz bardziej były zainteresowane rozwojem rozrywki, komunikacji, ułatwieniem codziennego życia z pomocą komputerów. Wrócono do marzeń sprzed wojny. Już wówczas przewidywano wyręczenie ludzi przez maszyny. Wejście komputerów w użycie sprawiło, że te marzenia stały się bliższe i bardziej realne.

Komputer coraz bardziej osobisty

Tranzystor i prawo Moore’a

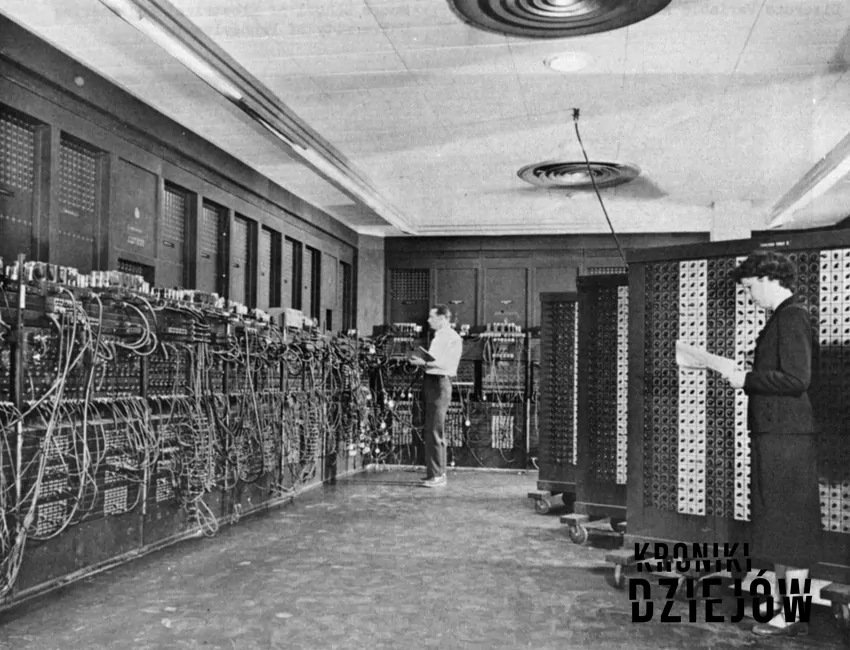

W roku 1946 pierwsze komputery miały już wszystkie podstawowe składniki, o których mówiłam wcześniej. Ich architektura nie różniła się zasadniczo od współczesnej. Mimo to zajmowały mnóstwo miejsca i wymagały wykwalifikowanej obsługi.

Wśród szeregu wynalazków, które usprawniły pracę komputera i pozwoliły na jego zmniejszenie i przyspieszenie, jednym z najważniejszych jest tranzystor.

Tranzystor jest elementem układu elektronicznego, który ma zdolność wzmacniania sygnału elektrycznego. Przed jego powstaniem używano do tego celu lamp próżniowych. Ich wielkość ograniczała możliwości miniaturyzacji pierwszych komputerów.

Głównym składnikiem umożliwiającym funkcjonowanie tranzystora jest materiał półprzewodnikowy. Najczęściej wykorzystywany jest krzem (silicon), stąd nazwa elektronicznego el dorado „Dolina Krzemowa” (Silicon Valley). Pierwszy działający tranzystor powstał w laboratoriach Bella w 1947 roku. (por. Ritchie D.: s. 120) W ciągu lat 50-tych udoskonalano konstrukcję. W 1958 roku Jack Kilby i Robert Noyce niezależnie od siebie zbudowali z tranzystorów pierwsze układy scalone.

Zaraz po pojawieniu się działającego tranzystora na rynku zaczęto eksperymentować z zastosowaniem go w komputerach. Jednak dopiero powstanie układu scalonego stało się podstawą do prawdziwego rozwoju komputerów (i innych urządzeń elektronicznych). Rozwój był tak szybki, że około 1965 roku George Moore, późniejszy współzałożyciel firmy Intel, stwierdził, że ilość tranzystorów w układzie scalonym będzie się corocznie podwajać. To tzw. prawo Moore’a było modyfikowane w kolejnych latach i zaczęto je odnosić do innych parametrów komputera t.j. pojemność pamięci czy szybkość taktowania procesora.

Od minikomputera do Altair 8800

Dziś moglibyśmy się zdziwić widząc co pod koniec lat 60-tych nazywano minikomputerem. Jeden z pierwszych modeli – PDP-8 – wyglądał jak średniej wielkości szafa, oczywiście nie licząc ewentualnych urządzeń peryferyjnych. Wielkie, wieloczęściowe komputery typu mainframe, używane były przez duże organizacje, ich cena przekraczała możliwości większości małych firm, o użytku domowym nie wspominając. Minikomputery były dostosowane do bardziej powszechnego użytku. To one dały początek komputerom osobistym. Nie tylko zajmowały mniej miejsca, ale łatwiej było wprowadzać dane za pomocą przełączników.

Wśród prekursorów PC-ta historycy cyfryzacji zgodnie wyróżniają model Altair 8800, wykorzystujący procesor Intela 8080. Wprowadzony przez firmę MITS był pierwszym komputerem, na który mógł sobie pozwolić prywatny użytkownik. Była to najbardziej minimalistyczna wersja komputera, bez pamięci zewnętrznej, klawiatury i innych urządzeń wejścia. Była też imponująco, jak na owe czasy, niewielka – rozmiarów sporej walizki.

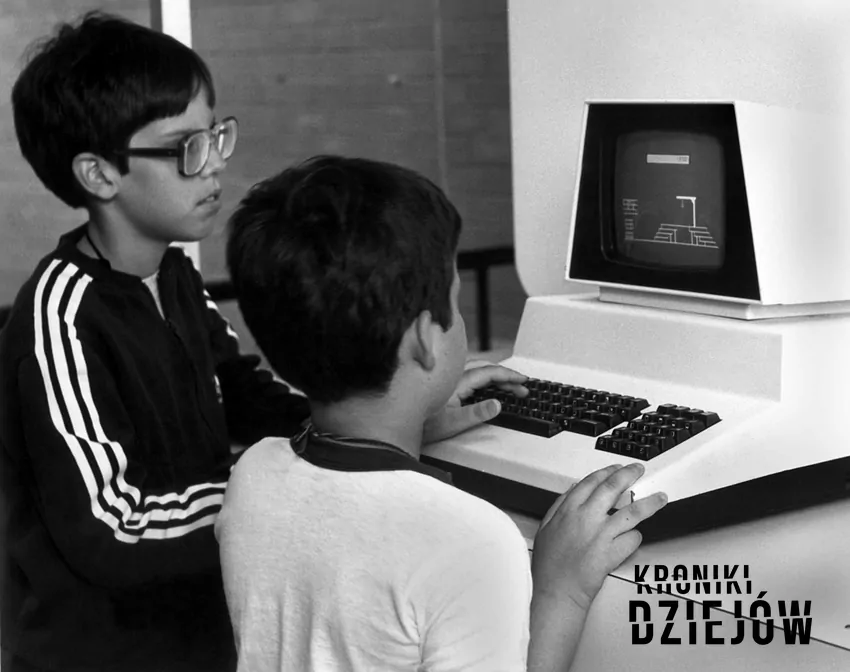

Dostępność Altair 8800 umożliwiła powstanie komputerów, z których mogli korzystać naprawdę wszyscy. Jego użyteczność dla niespecjalistów wzrosła kiedy w 1975 roku Bill Gates i Paul Allen napisali język programowania Altair Basic (później nazwany Microsoft Basic), oparty na opracowanym wcześniej edukacyjnym języku Basic. (Lee J.A.N., 1995: s. 413) Kolejne udoskonalenia sprawiły, że dość surowa maszyna, jaką był „goły” Altair 8080, przekształciła się w prawdziwy komputer osobisty, z programami, grami i możliwością nauki. Podłączenie monitora i klawiatury pozwalało z niego normalnie korzystać.

II połowa lat 70-tych i początek lat 80-tych to kolejne udoskonalenia związane z rozwojem komputerów osobistych. Miniaturyzacja urządzeń była połączona z coraz wydajniejszą pracą.

Można się spierać jakie wydarzenie rozpoczęło erę cyfrową, jednak na pewno przypieczętowało ją rozpowszechnienie internetu. Komputery osobiste były nie tylko powszechnie dostępne i łatwe w obsłudze, ale zapewniały dostęp do światowej bazy informacyjnej. Ale to już temat na inny artykuł.

Autor: Ludwika Wykurz

Bibliografia:

- Charles Petzold, Kod. Ukryty język sprzętu komputerowego i oprogramowania, Warszawa 2002

- David Ritchie, The computer pioneers: the making of the modern computer, New York 1986

- John A.N. Lee, International biographical dictionary of computer pioneers, Chicago 1995